Nos filmes de ficção científica, é comum vermos robôs que choram, riem ou sentem raiva. Mas, na realidade, será que eles conseguem mesmo sentir e entender as emoções humanas? A resposta, por ora, é: eles estão tentando[1].

A Inteligência Artificial Emocional, também chamada de Computação Afetiva, é uma área multidisciplinar que une ciência da computação, psicologia e neurociência para ensinar máquinas a reconhecer, interpretar e até simular emoções humanas[2].

A IA Emocional desponta como uma das fronteiras mais fascinantes e controversas da tecnologia atual. É provável que num futuro próximo as interações com as máquinas se tornem ainda mais naturais e imperceptíveis.

O que é IA a Emocional?

O termo Affective Computing (Computação Afetiva) foi cunhado em 1995 pela pesquisadora Rosalind Picard, do MIT Media Lab[3]. Desde então, a chamada IA Emocional cresceu com o objetivo de tornar as máquinas sensíveis às expressões emocionais humanas – ou seja, capazes não apenas de entender nossas emoções, mas de reagir de forma adequada a elas[4].

As aplicações potenciais são amplas: vão desde assistentes virtuais e chatbots mais empáticos, passando por educação adaptativa, marketing, recursos humanos e detecção precoce de transtornos de saúde mental[5].

Como Funciona a IA Emocional?

Ensinar uma máquina a “ler” emoções envolve programá-la para analisar múltiplos sinais comportamentais emitidos pelas pessoas[6].

Em geral, os sistemas de IA Emocional capturam e interpretam, principalmente, os seguintes indícios:

- Expressões faciais: microexpressões e mudanças faciais identificadas via câmeras.

- Tom de voz e prosódia: análise da entonação, ritmo, volume e padrões da voz durante a fala. Por exemplo, uma voz trêmula pode indicar nervosismo [7].

- Sinais fisiológicos: dados coletados por sensores, como batimentos cardíacos, suor, dilatação das pupilas ou respiração. [8].

- Linguagem corporal e gestos: postura do corpo, movimentos das mãos, inclinação da cabeça e outros gestos capturados por vídeo [7].

- Análise de texto escrito: algoritmos de IA podem identificar sentimentos em mensagens ou publicações, procurando palavras e construções associadas a alegria, tristeza, sarcasmo, etc.[9].

Com esses dados os algoritmos de IA classificam probabilisticamente a emoção. Por exemplo, a combinação de sobrancelhas erguidas + olhos arregalados + boca entreaberta pode indicar surpresa; já uma postura curvada + silêncio prolongado pode sinalizar desânimo.

Empresas líderes nesse setor construíram imensos bancos de dados para treinar seus modelos: a Affectiva (affectiva.com), por exemplo, já analisou mais de 10 milhões de rostos em 90 países, criando uma das maiores bases de dados emocionais do mundo[10].

Apesar do nome, a IA emocional não “sente” nada de fato. Ela identifica padrões objetivos como expressões, tons, sinais e, a partir deles, estima qual emoção pode estar ocorrendo[11].

Aplicações Atuais da IA Emocional

Assistentes Virtuais “Empáticos”: Alguns assistentes virtuais e chatbots oferecem consolo quando detectam que o usuário está passando por um momento difícil, ou inserem um tom de humor para animar o usuário[12]. Em centrais de atendimento ao cliente, tecnologias assim já são usadas para adaptar o tom das respostas automáticas conforme a irritação do cliente, ou mesmo direcionar chamadas mais delicadas para atendentes humanos[13].

Robôs Sociais na Educação:

Beo, um robô brasileiro auxilia na aprendizagem de crianças com autismo.Ele atua como companheiro de alunos ajudando a manter o interesse e facilitando a compreensão de conteúdos complexos por meio de interações afetivas[15]. Algumas plataformas de aprendizagem com IA já conseguem ajustar o conteúdo em tempo real conforme a emoção do aluno diminuindo o nível de dificuldade se ele estiver frustrado ou oferecendo novos desafios se estiver entediado[1].

Aplicações em Saúde e Bem-Estar: Chatbots terapêuticos estão sendo empregados para auxiliar pessoas em sofrimento psíquico: eles fornecem apoio inicial em crises de ansiedade ou depressão quando não há um humano disponível[16]. Um exemplo é o Woebot[2], assistente virtual que dialoga com pacientes usando técnicas de terapia cognitiva, monitorando o humor dia a dia. Já no campo dos robôs de companhia, um caso emblemático é o Paro[3]: um robozinho em forma de filhote de foca, macio e interativo, usado em terapias com idosos e pacientes com demência [17]. Estudos indicam que esses robôs podem reduzir a ansiedade e a sensação de solidão em casas de repouso, atuando como uma forma alternativa de pet-terapia[18].

Brinquedos emotoys: um brinquedo que é um companheiro inteligente e interativo, como um robô para crianças, que interage de forma emocional com o utilizador.

O lado sombrio

As inovações em IA Emocional trazem questionamentos:

- Empatia Simulada: por mais avançada que seja a IA, ela não possui emoções reais. Seus algoritmos correlacionam sinais observáveis a estados prováveis, mas não “sentem” alegria, tristeza ou empatia de fato[11]. Em outras palavras, trata-se de uma simulação estatística baseada em dados. Os robôs afetivos fornecem apenas a ilusão de um relacionamento. Existe o risco de pessoas solitárias ou vulneráveis se apegarem a eles como amigos, mesmo que a máquina seja incapaz de reciprocidade ou compaixão genuína[21].

- Manipulação Emocional: outra preocupação é o uso indevido dessas tecnologias para manipular pessoas. Imagine campanhas de marketing ou políticas ajustando mensagens em tempo real para explorar emoções específicas do usuário. Pesquisadores alertam que os dados emocionais podem ser usados para prever estados mentais e manipular comportamentos ou decisões [22].

- Privacidade: a coleta massiva de informações afetivas como expressões faciais, voz e frequência cardíaca, levanta sérios problemas de privacidade e consentimento. Muitas vezes esses dados podem ser capturados sem que o usuário tenha plena ciência em câmeras espalhadas por todo lugar. Emoções são dados ultra-sensíveis, revelam aspectos íntimos que até nós mesmos[23]. Seu monitoramento e comercialização pode configurar uma nova forma de vigilância invisível.

- Fronteiras borradas: será cada vez mais difícil separar fantasia da vida real.

- Antropomorfismo enganoso: a IA parece sentir e se importar como um humano, mas não sente nada.

- Dependência emocional: usuários podem se apegar de forma prejudicial, afastando-se de amigos e família.

Casos extremos, como o processo judicial nos EUA envolvendo o Character.ai após o suicídio de um adolescente, acendem o alerta sobre a responsabilidade ética dessas plataformas.

Conclusão

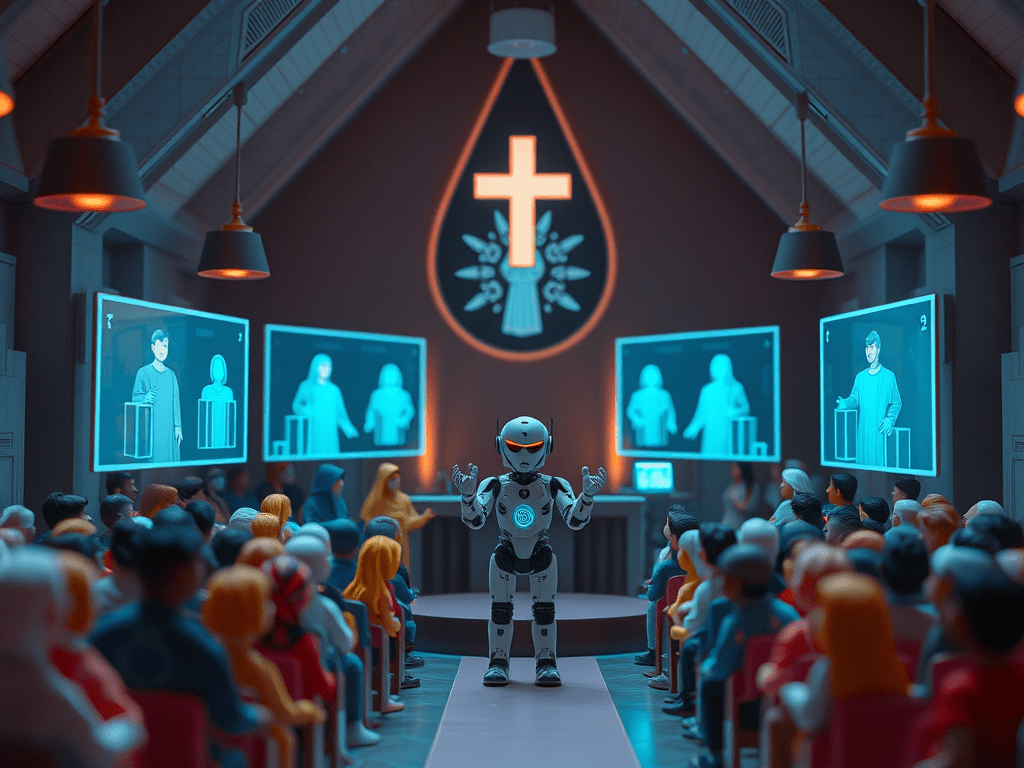

Diante de cenários tão novos, surge a necessidade de delimitar até onde a IA Emocional deve ir. Em contextos educativos e religiosos é preciso cautela para não delegar às máquinas aquilo que é próprio das pessoas. A IA emocional deve complementar, nunca substituir a interação humana profunda.

Por mais que um robô ou software seja hábil em parecer empático, ele não pode ocupar plenamente o lugar de um professor atencioso em sala de aula, de um pastor ou conselheiro espiritual ao ouvir um desabafo.

Referências

[1] [2] [3] [4] [5] [6] [7] [8] [9] [10] [11] [13] [14] [23] [26] [27] [28] [29] [30] [31] IA Emocional: Como Algoritmos Estão Tentando Compreender Afetos Humanos – Eduvem

[12] [16] [20] [22] [24] [25] Emoções simuladas: devemos nos importar com máquinas que fingem sentir? | by José Augusto de Lima Prestes | Medium

[15] BEO, O ROBÔ SOCIAL

[17] [21] Paro (robô) – Wikipédia, a enciclopédia livre

https://pt.wikipedia.org/wiki/Paro_(rob%C3%B4)

[18] [19] Conheça o robô-foca que auxilia no tratamento de demência – SIMI

https://simi.mg.gov.br/conheca-o-robo-foca-que-auxilia-no-tratamento-de-demencia

Bakir, V., McStay, A. Move fast and break people? Ethics, companion apps, and the case of Character.ai. AI & Soc (2025). https://doi.org/10.1007/s00146-025-02408-5

Publicações e relatórios sobre o tema: https://emotionalai.org/outputs

Emotoys: https://journals.sagepub.com/doi/10.1177/2053951721994877

[1] https://www.khanmigo.ai/pt

[2] https://exame.com/tecnologia/novo-aplicativo-informa-ao-usuario-quando-ele-esta-deprimido/

Deixe um comentário