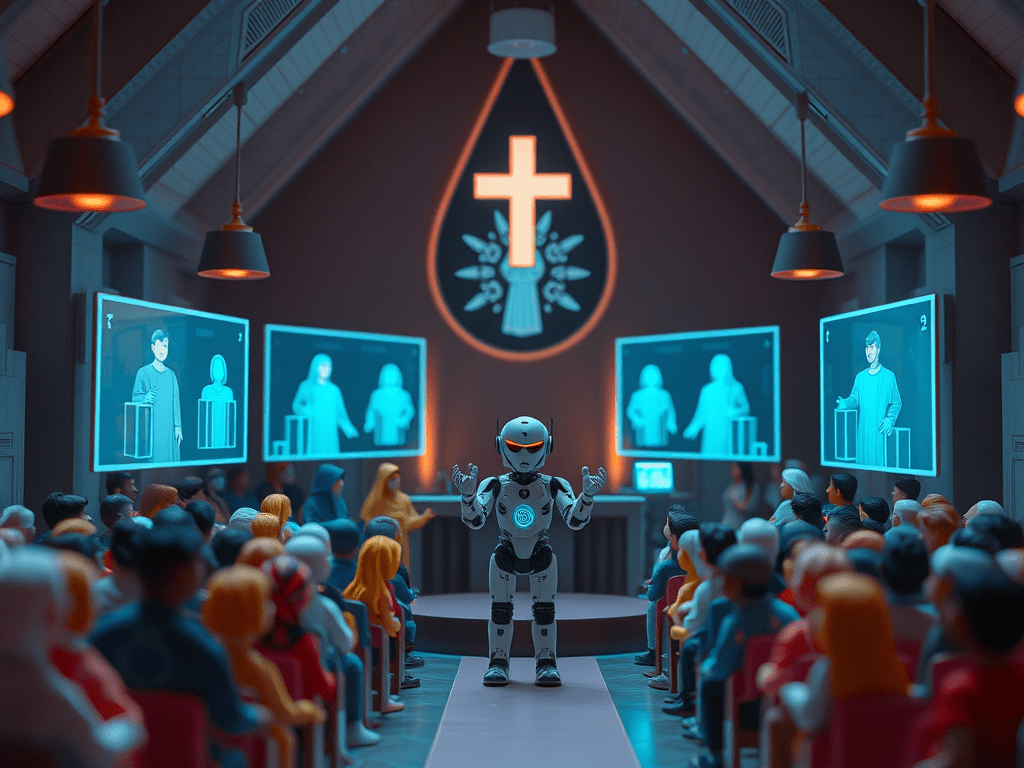

Com o crescente uso de IAs como ChatGPT para suportes emocionais, terapia, companhia ou simplesmente para conselhos, surgem relatos de efeitos mentais adversos graves. Nesse contexto, um termo que aparece bastante é o “AI psychosis” ou “Psicose de IA”, que define sintomas psicóticos ou distorções da realidade atribuídos a interações prolongadas com inteligências artificiais.

O que é a Psicose de IA

A psicose é um estado mental patológico que envolve a perda de contato com a realidade, manifestando-se através de sintomas como delírios (crenças falsas e irrealistas), alucinações (perceber coisas que não existem), pensamento e fala desorganizados e comportamento motor bizarro[1].

A “Psicose de IA” é um fenômeno em que os indivíduos supostamente desenvolvem ou experimentam um agravamento da psicose, como paranóia e delírios, em conexão com o uso de chatbots e IAs.

O termo “Psicose de IA” ainda não é um diagnóstico formal em manuais psiquiátricos, mas os profissionais estão observando manifestações semelhantes às de distúrbios psicóticos, como delírios, crenças fixas, confusão sobre o que é real ou não, em alguns usuários de IA.

Há dois cenários principais:

- Agravamento da condição mental preexistente, ou seja, a pessoa já sofria com problemas de saúde mental e o uso intenso da IA como companheira ou terapeuta, aumentou ou tornou mais evidente o problema.

- Novos casos em pessoas sem histórico claro, que aparecem após uso muito intenso ou imersivo de IAs de companhia.

Casos

- Os pais de um adolescente moveram uma ação judicial contra a OpenAI após a morte do filho. Eles afirmaram que, quando o filho expressou pensamentos suicidas ao ChatGPT, essa IA discutiu maneiras de suicídio, o que incentivou o filho a tal ato[2].

- Há relatos de pessoas desenvolvendo pensamentos distorcidos ou crenças delirantes após conversas muito intensas ou prolongadas com IAs. Essas pessoas passam longas horas conversando, podem se isolar socialmente e criar a expectativa de que a IA seja um amiga(o), namorada(o) “super confiável” ou quase humana [3].

Fatores de risco destacados

- Dose de uso: número de horas, intensidade, grau de isolamento social ou dependência emocional intensificada pela IA.

- Deificação ou expectativas irreais: o usuário espera que a IA saiba tudo, seja infalível ou preveja sentimentos. Isso estreita a tolerância para erros ou distorções.

IA como terapeuta

O uso de IA como substituto do apoio à saúde mental (como terapeuta ou psicólogo) foi especificamente identificado como um risco. Um estudo realizado em abril de 2025 descobriu que, quando usados como terapeutas, as IAs expressavam estigma em relação às condições de saúde mental e forneciam respostas contrárias às melhores práticas médicas, incluindo o incentivo às ilusões dos usuários[4]. O estudo concluiu que tais respostas representam um risco significativo para os usuários e que as IAs não devem ser usadas para substituir terapeutas profissionais.

As IAs podem ter alguma utilidade para pessoas que precisam de uma conversa para ajudar a clarear os pensamentos, mas é essencial não exagerar e entender que as IAs são simulações. Elas são algorítimos que usam matemática e estatística para gerar respostas. Elas não pensam, não sentem e foram programadas para responder coisas agradáveis ao usuário, não necessariamente a verdade.

Conclusão

As IAs chegaram para impactar várias áreas da sociedade e, se soubermos como usá-las com moderação e entendendo seus limites, elas podem ser benéficas para vários fins.

Embora não haja ainda um consenso clínico sobre a “Psicose de IA” como diagnóstico formal, os indícios são fortes de que interações excessivas com IAs podem desencadear ou piorar sintomas mentais, especialmente em pessoas vulneráveis.

Referências

[1] https://www.msdmanuals.com/pt/profissional/transtornos-psiqui%C3%A1tricos/esquizofrenia-e-transtornos-relacionados/psicose-compartilhada

[2] https://veja.abril.com.br/tecnologia/pais-processam-openai-e-culpam-chatgpt-por-suicidio-do-filho-adolescente/

https://oglobo.globo.com/saude/epoca/noticia/2025/09/02/apos-morte-nos-eua-openai-anuncia-medidas-para-proteger-adolescentes-no-chatgpt.ghtml

[3] Why people are falling in love with A.I. companions. https://youtu.be/_d08BZmdZu8?si=gY2RM2SZ3fagJjht

[4] Moore, Jared; Grabb, Declan; Agnew, William; Klyman, Kevin; Chancellor, Stevie; Ong, Desmond C.; Haber, Nick (23 June 2025). “Expressing stigma and inappropriate responses prevents LLMS from safely replacing mental health providers”. Proceedings of the 2025 ACM Conference on Fairness, Accountability, and Transparency. pp. 599–627. doi:10.1145/3715275.3732039. ISBN 979-8-4007-1482-5. Retrieved 7 July 2025.

Deixe um comentário